Het officiële persbericht

Vraag vandaag de dag een doorsnee IT-professional of ze AI inzetten en de kans is groot dat ze ja zeggen - ze hebben tenslotte reputaties te beschermen! Maar alle gekheid op een stokje, velen zullen melden dat hun teams gebruik maken van webgebaseerde tools zoals ChatGPT of zelfs interne chatbots hebben die hun werknemers bedienen op hun intranet, maar dat er niet echt veel AI wordt geïmplementeerd op infrastructuurniveau. Het echte antwoord is een beetje anders. AI-tools en -technieken hebben zichzelf stevig verankerd in standaard bedrijfsworkloads en zijn een gewoner, alledaags fenomeen dan zelfs veel IT’ers zich realiseren. Inspecties aan de lopende band worden nu uitgevoerd met behulp van computervisie. Toeleveringsketens gebruiken AI voor het voorspellen van de vraag, waardoor zaken sneller verlopen en natuurlijk is het maken van notities en het samenvatten van vergaderingen met behulp van AI ingebed in vrijwel alle varianten van samenwerkings- en vergadersoftware.

Steeds meer cruciale softwaretools voor bedrijven bevatten ingebouwde aanbevelingssystemen, virtuele agenten of een andere vorm van AI-ondersteuning. AI wordt echt een alomtegenwoordige, aanvullende tool voor het dagelijkse bedrijfsleven. Tegelijkertijd bewegen bedrijven zich in een hybride landschap waar traditionele, bedrijfskritische werklasten naast innovatieve AI-gedreven taken bestaan. Deze “gemengde bedrijfs- en AI" werkomgeving vraagt om een infrastructuur die beide soorten verwerking naadloos aankan. Robuuste CPU’s voor algemeen gebruik, zoals de AMD EPYC-processors, zijn ontworpen om krachtig, veilig en flexibel in deze behoefte te voorzien. Ze kunnen alledaagse taken aan, zoals het draaien van databases, webservers en ERP-systemen, en bieden sterke beveiligingsfuncties die cruciaal zijn voor bedrijfsactiviteiten aangevuld met AI-workloads. In essentie draait moderne bedrijfsinfrastructuur om het creëren van een gebalanceerd ecosysteem. AMD EPYC CPU’s spelen een cruciale rol bij het creëren van deze balans door hoge prestaties, efficiëntie en beveiligingsfuncties te leveren die zowel traditionele zakelijke workloads als geavanceerde AI operaties ondersteunen.

Wanneer CPU-inferentie zinvol is

Om te bepalen welke werkbelastingen goed geschikt zijn voor CPU-inferentie, zijn er vier potentiële kenmerken voor gebruik:

- Hoge geheugencapaciteit: Grotere geheugencapaciteit voor grotere modellen en uitgebreidere toestandsinformatie die moet worden bijgehouden tijdens inferentie.

- Lage latentie: Kleine en middelgrote modellen met realtime, sporadische of weinig gelijktijdige inferentieverzoeken.

- Batch/offline verwerking: Onbegrensde latency of waar batchverwerking kan worden gebruikt om werklasten van grote volumes te verwerken.

- Kosten en energie-efficiëntie: Gevoeligheid voor energieverbruik en kosten, zowel CAPEX als OPEX

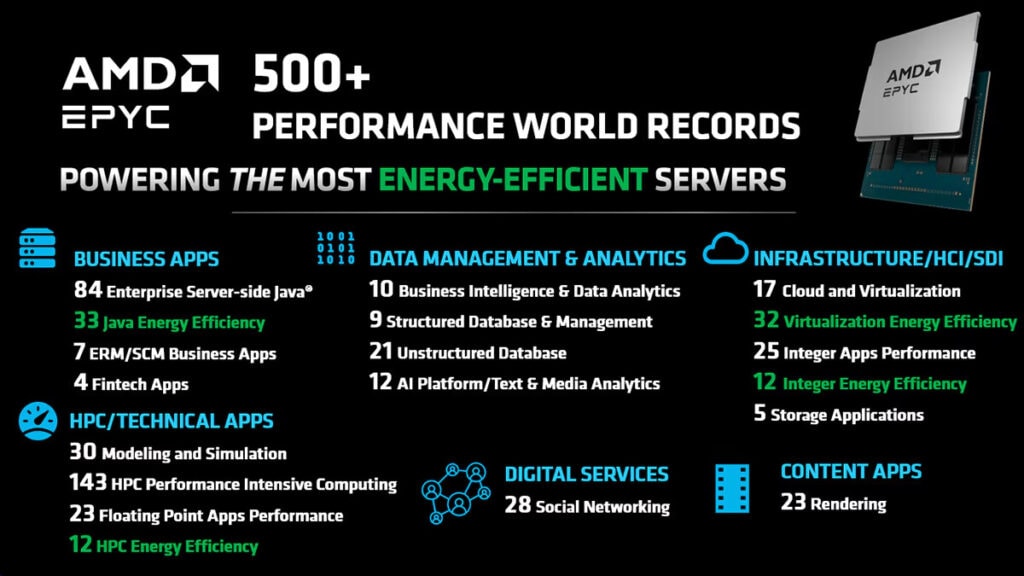

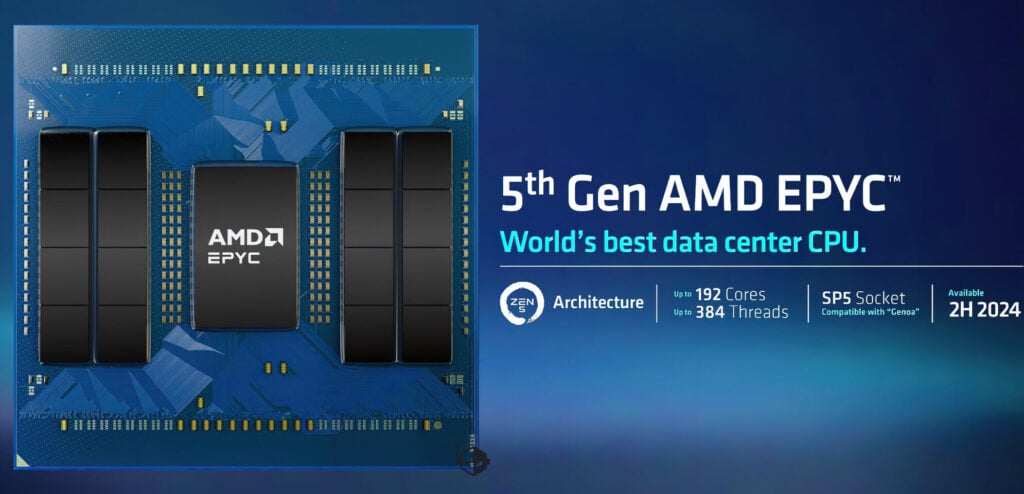

Deze eigenschappen maken de 5e generatie AMD EPYC-processoren tot een strategische keuze voor het verwerken van AI-inferentie. Het is tenslotte geen toeval dat deze CPU’s met het hoogste aantal kernen van x86 CPU’s in de industrie de parallelle architecturen kunnen ondersteunen die fundamenteel zijn voor AI-modellen. Bovendien zorgen de nabijheid, snelheid en totale geheugencapaciteit ervoor dat AI-modellen snel en eenvoudig toegang hebben tot de cache met sleutelwaarden, waardoor modellen efficiënter kunnen werken. Het is ook geen verrassing dat AMD EPYC CPU’s honderden wereldrecords hebben gevestigd op het gebied van prestaties en efficiëntie, waarmee ze hun leiderschap hebben bewezen voor een breed scala aan universele computertaken.

Werklasten die geschikt zijn voor CPU-inferentie

Zoals we hebben gezien, bepalen de karakteristieken van een werklast of een werklast geschikt is voor een CPU. De meest voorkomende soorten werklasten die herhaaldelijk op CPU’s worden uitgevoerd zijn klassieke machine learning, aanbevelingssystemen, natuurlijke taalverwerking, generatieve AI, zoals taalmodellen, en collaborative prompt-based pre-processing. We gaan dieper in op elk van deze werklasten en waarom ze geschikt zijn voor inferentie op 5e generatie AMD EPYC-processors.

Klassiek machinaal leren

Gangbare voorbeelden van modellen voor machinaal leren zijn beslisbomen en lineaire regressiemodellen. Deze algoritmen hebben meestal een meer sequentiële architectuur dan AI-modellen en bevatten matrixbewerkingen en regelgebaseerde logica in tegenstelling tot diepe neurale netwerken. CPU’s zijn zeer geschikt voor het efficiënt afhandelen van scalaire bewerkingen en vertakkende logica. Daarnaast werken klassieke ML algoritmen op gestructureerde datasets die in het geheugen passen. CPU’s bieden door hun lage geheugentoegangslatentie en grote geheugencapaciteit een enorme prestatie-optimalisatie.

Aanbevelingssystemen

Denk aan de manier waarop sociale media feeds en online winkelen worden samengesteld met aanbevelingen. Deze systemen gebruiken diverse algoritmes zoals collaboratieve filtering en filtering op basis van inhoud en vereisen de verwerking van een grote verscheidenheid aan datasets van itemkenmerken, gebruikersdemografie en interactiegeschiedenis. Om deze grote verscheidenheid te ondersteunen is flexibiliteit nodig, waarvoor CPU’s ideaal zijn. Aanbevelingensystemen vereisen ook een grote geheugentoegang met lage latency om hele datasets optimaal op te slaan en tabellen in het geheugen in te sluiten voor snelle, frequente toegang, waar CPU’s zeer geschikt voor zijn.

Natuurlijke taalverwerking

Chatbots en tekst-naar-spraak- of spraak-naar-tekst-toepassingen werken vaak met natuurlijke taalverwerkingsmodellen. Deze modellen zijn compact en bedoeld om in een real-time conversatiescenario te draaien. Aangezien de reactietijd van mensen binnen enkele seconden ligt, zijn deze toepassingen vanuit rekenstandpunt niet erg gevoelig voor latentie, waardoor reacties binnen milliseconden nodig zijn. Door gebruik te maken van 5e generatie AMD EPYC CPU’s met hoge core count kunnen meerdere gelijktijdige instances op één CPU passen en een aantrekkelijke prijs-prestatieverhouding voor deze werklasten bieden.

Generatieve AI inclusief taalmodellen

Veel bedrijfsapplicaties die zijn overgestapt van kleine chatbotapplicaties maken nu gebruik van generatieve modellen om de creatie van content te stroomlijnen en te versnellen. Het meest voorkomende type generatief model zijn taalmodellen. Kleine en middelgrote taalmodellen draaien efficiënt op CPU’s. Het hoge aantal cores en de grote geheugencapaciteit van de 5e generatie AMD EPYC-processors kunnen real-time inferentie ondersteunen die responsief genoeg is voor de meeste gangbare use cases zoals chatbots of zoekmachines en ideaal voor batch/offline inferentie waarbij een ontspannen reactietijd nodig is. Voor AMD EPYC geoptimaliseerde bibliotheken bieden extra parallellisme en opties om multi-instances te draaien waardoor de verwerkingscapaciteit wordt verbeterd.

Collaborative Prompt-gebaseerde voorbewerking

Collaboratieve modellen zijn een nieuwere categorie modellen die erg klein en efficiënt zijn voor het voorbewerken van gegevens of de vraag van de gebruiker om de inferentie te stroomlijnen voor een groter model stroomafwaarts. Deze kleine modellen die worden gebruikt in retrieval augmented generation (RAG) en speculatieve decodering van AI-oplossingen zijn zeer geschikt om op een CPU te draaien en worden vaak gebruikt in een “gemengd" scenario waarbij inferentie wordt uitgevoerd op de host-CPU ter ondersteuning van GPU’s die grote inferentiewerklasten uitvoeren.

Deze werklasten omvatten een grote verscheidenheid en worden elk gebruikt in meerdere toepassingen in verschillende industriesegmenten. De reeks eindtoepassingen waarin deze workloads passen is eindeloos, waardoor de toepassingen voor CPU-gebaseerde inferentie ook eindeloos zijn. Of het nu gaat om het stroomlijnen van toeleveringsketens met vraagvoorspelling op basis van tijdreeksen en klassieke machine-learningmodellen, of om het verkleinen van de CO2-voetafdruk met voorspellende analyses zoals XGBoost om emissies te voorspellen, of om het verbeteren van de klantervaring met in-store deals en couponleveringen, CPU’s zijn de drijvende kracht achter de dagelijkse AI-inferentie. Hoewel elk van deze typen werklasten met gemak op een CPU kunnen bestaan, maken in elk voorbeeld het hoge aantal kernen, de architectuur met hoge geheugencapaciteit die is gebouwd om een balans te vinden tussen geserialiseerde en parallelle werklasten en de flexibiliteit om meerdere werklasten en gegevenstypen te ondersteunen, de 5e generatie AMD EPYC-processoren de ideale keuze voor CPU-inferentie.

Oplossingen voor het evoluerende spectrum van AI

AMD EPYC-processors geven je de ruimte om te groeien en te evolueren. Niet alleen helpen ze bij het consolideren van legacy servers in uw datacenter om ruimte en stroom vrij te maken, ze bieden ook flexibiliteit om te voldoen aan uw AI workload behoeften, ongeacht de grootte en schaal. Voor kleinschalige AI-implementaties leveren 5e generatie AMD EPYC CPU’s een uitzonderlijke prijs-prestatieverhouding en voor grootschalige implementaties, of er nu 1 of honderdduizenden GPU’s nodig zijn, helpen ze maximale verwerkingscapaciteit te halen uit uw AI-workload.

Vooruitgang staat niet stil. De toekomst is ondoorzichtig, dus of modellen nu kleiner en efficiënter worden, of groter en capabeler (of beide!) 5e generatie AMD EPYC CPU’s bieden flexibiliteit om zich aan te passen aan het veranderende AI-landschap. Om uw klanten de beste producten en diensten tegen de juiste prijs te kunnen bieden, moet u zich kunnen aanpassen. Een AMD EPYC CPU-gebaseerde server kan zich samen met u aanpassen. Ga aan de slag met AI op AMD EPYC met onze out-of-the-box ondersteuning voor Pytorch-modellen en ontdek hoe we u kunnen helpen uw prestaties te optimaliseren met ZenDNN.

Bronnen: TechPowerUp, AMD Community Blog